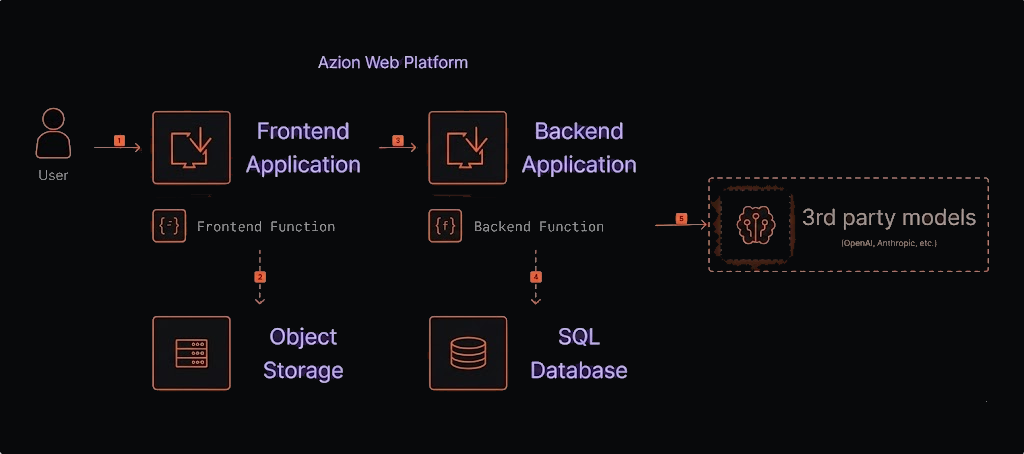

Esta arquitetura descreve um agente de IA no edge que consome Third Party LLM por API, armazena o estado no SQL Database e prioriza latência mínima.

Diagrama de arquitetura de AI Agent da Azion com integração Third party

Figura 1. Diagrama de arquitetura do agente de IA com um Third Party LLM.

Fluxo de dados

- Uma requisição chega à Plataforma Web da Azion.

- A Aplicação Frontend serve a interface do usuário (com arquivos estáticos do Object Storage, ex.: CSS, HTML, etc.).

- A aplicação frontend envia uma requisição de API para a function backend.

- A function backend lê/escreve o estado do chat no SQL para persistência e contexto, então executa o agente LangGraph e transmite a resposta para o cliente.

- O agente chama Third Party LLMs, processa a entrada do usuário usando dados do banco de dados para formular uma resposta, e a envia de volta ao usuário pelo mesmo caminho.

- A aplicação Frontend exibe a resposta para o usuário.

Componentes

- Applications: uma aplicação na Azion que hospeda o agente de IA.

- Functions: uma função serverless que contém a lógica do agente de IA.

- Object Storage: serviço de armazenamento de objetos da Azion para armazenar os dados que o agente usa para responder às perguntas.

- SQL Database: banco de dados da Azion para armazenar o estado do chat e documentos.

- Third Party LLM: serviço de LLM (ex.: OpenAI ou Anthropic).

Implementação

Utilize o LangGraph AI Agent Boilerplate para montar rapidamente um backend em LangGraph e uma base SQL que garante persistência confiável de estado e documentos.

Você pode obter e configurar seu template pelo Azion Console. Para implantá-lo facilmente no edge, clique no botão abaixo.

Implantar- Acesse o Azion Console.

- Clique em

+ Createpara abrir a página de templates. - Selecione

LangGraph AI Agent Boilerplate. - Conecte seu GitHub, defina o nome do agente e informe as chaves necessárias (ex.: OpenAI API Key).

- Escolha o método de autenticação (No Auth, Basic, Clerk) e finalize com

Deploy. - Aguarde a propagação e acesse o domínio

your-url.map.azionedge.net(ou seu domínio personalizado).

Upload de arquivos na plataforma

Uma vez o processo acima foi implementado, seu banco de dados já está configurado e pronto para uso. Vamos carregar os documentos que o agente utilizará como contexto.

- Clone localmente o backend do template implementado na sua conta do Github.

- Crie um arquivo .env com as configurações necessárias para o backend do template.

ZION_TOKEN='your_azion_personal_token'OPENAI_API_KEY='API_KEY'OPENAI_MODEL= 'model'EMBEDDING_MODEL= 'embedding-model'

# SQL Database and table names. Usually, table names are not changed,# and the database name is the name of your agent + database: agent_name_databaseMESSAGE_STORE_DB_NAME='youragent-database'MESSAGE_STORE_TABLE_NAME='messages'VECTOR_STORE_DB_NAME='youragent-database'VECTOR_STORE_TABLE_NAME='vectors'

# Optional: Langsmith to trace the requests and responsesLANGSMITH_API_KEY=LANGCHAIN_PROJECT=LANGCHAIN_TRACING_V2=false

# Optional: Clerk authentication with your frontendCLERK_PUBLISHABLE_KEY=CLERK_SECRET_KEY=- Insira os arquivos desejados na subpasta

filesdo diretóriomigrations. Se a pasta não existir, crie-a. Atualmente, são suportados arquivos PDF, MD, JSON e TXT. - No terminal, vá para a pasta

migrationse execute o comandoyarn setuppara criar as tabelas no banco de dados. - Em seguida, execute o comando

yarn upload-docspara fazer upload dos arquivos para o Object Storage.

Guia de Referência

Documentação Relacionada

- Object Storage

- SQL Database

- Como configurar um domínio personalizado

- Azion GitHub App

- Vector Search com SQL Database