La nueva era de personalización de modelos

Los modelos de IA tradicionalmente requieren ajuste fino intensivo en recursos para satisfacer necesidades comerciales específicas, creando barreras para muchos desarrolladores y organizaciones debido a costos prohibitivos y ciclos de desarrollo largos.

Desafío clave: Adaptar modelos de miles de millones de parámetros eficientementeProblema tradicional: Altos costos computacionales + desarrollo prolongadoSin embargo, las nuevas técnicas de adaptación eficiente están democratizando el acceso a la IA. El ajuste fino LoRA (Adaptación de Bajo Rango) surge como una solución líder, permitiendo a los desarrolladores especializar modelos preentrenados para tareas específicas, como ajustar accesorios específicos a herramientas de propósito general.

LoRA maximiza el desempeño mientras minimiza la sobrecarga computacional y la huella de memoria. Este cambio de paradigma permite a los desarrolladores crear modelos personalizados de alto desempeño sin las inversiones masivas tradicionalmente requeridas para el ajuste fino completo, desbloqueando nuevos niveles de agilidad en el desarrollo de IA.

Comprender la base: preentrenamiento vs. ajuste fino

Antes de profundizar en LoRA, es esencial comprender la distinción entre preentrenamiento y ajuste fino. El preentrenamiento es el proceso fundamental de construir un modelo desde cero. Esto involucra alimentar un modelo con un conjunto de datos masivo y diverso y permitirle aprender todos sus parámetros desde la base. Esta es una tarea monumental, que demanda recursos computacionales inmensos y una vasta cantidad de datos.

El ajuste fino es un enfoque más dirigido. Comienza con un modelo preentrenado que ya posee una comprensión amplia de un tema. Un desarrollador entonces hace pequeños ajustes a los parámetros del modelo para refinarlo para una tarea específica posterior. Este proceso requiere significativamente menos datos y poder computacional que preentrenar un modelo desde cero. Sin embargo, incluso el ajuste fino tradicional puede ser costoso y consumir mucho tiempo, ya que aún requiere modificar todo el conjunto de parámetros.

Cómo funciona el ajuste fino LoRA

En su núcleo, la Adaptación de Bajo Rango (LoRA) es una técnica para adaptar rápidamente modelos de aprendizaje automático a nuevos contextos sin reentrenar todo el modelo. El método funciona agregando pequeñas partes modificables al modelo original, en lugar de alterar toda la estructura. Este enfoque ayuda a los desarrolladores expandir los casos de uso para sus modelos de una manera mucho más rápida y eficiente en recursos.

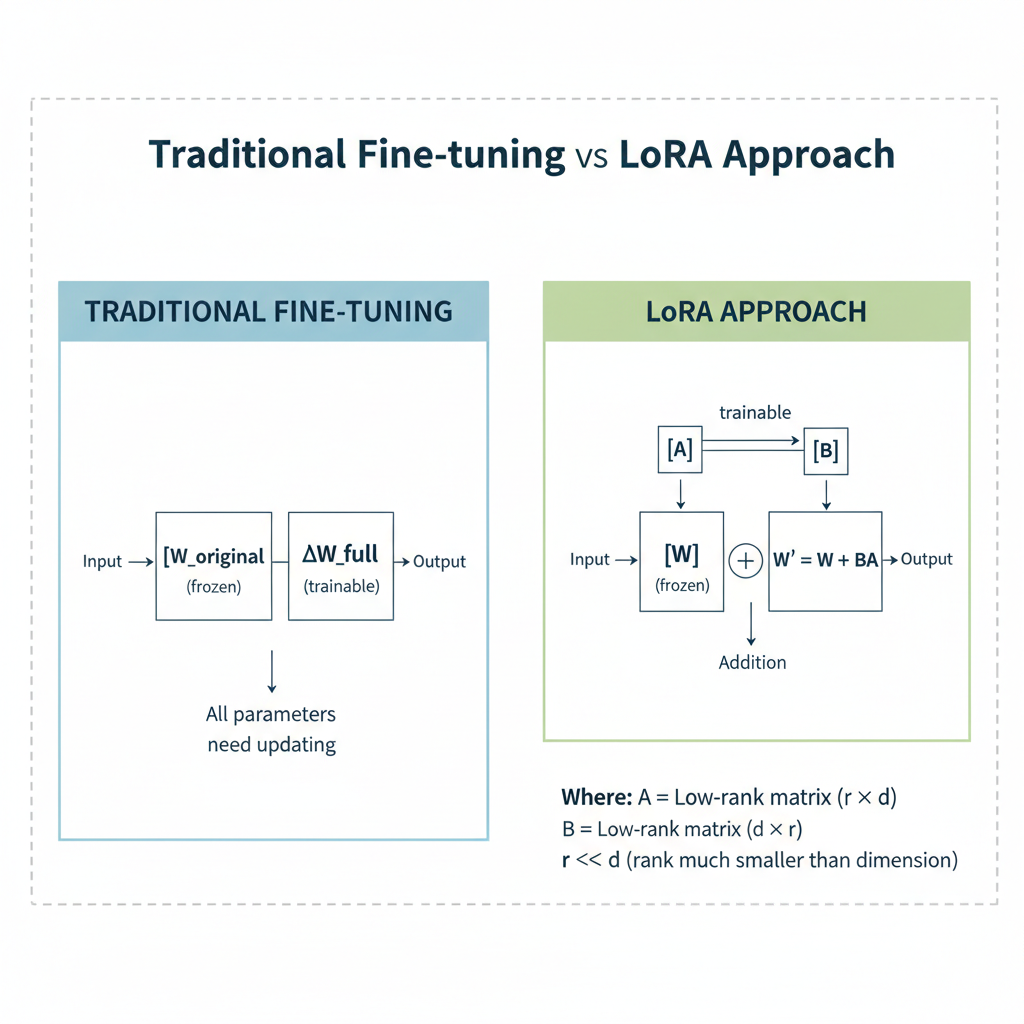

El genio técnico de LoRA radica en su uso de “matrices de bajo rango”. En el ajuste fino tradicional, el objetivo es cambiar la matriz de peso original (W) de una red neuronal para ajustarse a una nueva tarea. El cambio en sí se representa por una matriz separada, ΔW. LoRA introduce un atajo inteligente: en lugar de tratar de calcular y aplicar la matriz ΔW completa y compleja, la descompone en dos matrices mucho más pequeñas y de menor rango, A y B. La matriz de peso actualizada se convierte en W′=W+B·A, donde la matriz de peso original (W) se mantiene “congelada” e inalterada.

Tradicional: W' = W + ΔWLoRA: W' = W + B·ADonde:- W = Matriz de peso original (congelada)- ΔW = Matriz de actualización de parámetros completa- A = Matriz de bajo rango (entrenable)- B = Matriz de bajo rango (entrenable)- B·A = Aproximación de bajo rango de ΔWEsta descomposición es crucial para reducir la sobrecarga computacional. El número de parámetros entrenables se reduce dramáticamente porque las matrices pequeñas A y B tienen muchos menos valores que la matriz de peso original. Por ejemplo, una matriz de peso grande podría tener miles de millones de parámetros, pero con LoRA, los parámetros entrenables para un modelo como GPT-3 pueden reducirse de 175 mil millones a alrededor de 18 millones. Esto resulta en ahorros significativos en memoria GPU y poder de procesamiento, haciendo que sea una solución altamente rentable para adaptar modelos grandes.

Comparación de reducción de parámetros

| Componente del modelo | Ajuste fino tradicional | Ajuste fino LoRA |

|---|---|---|

| Parámetros GPT-3 | 175 mil millones | ~18 millones |

| Factor de reducción | 1× (línea base) | ~9,700× más pequeño |

| Uso de memoria | Alto | Significativamente reducido |

| Velocidad de entrenamiento | Lenta | Rápida |

| Costo | Alto | Bajo |

Las ventajas de LoRA sobre el ajuste fino completo

LoRA brinda varios beneficios clave que lo convierten en una alternativa atractiva al ajuste fino completo.

Comparación práctica

| Etapa | Ejemplo GPT | Recursos requeridos | Tiempo |

|---|---|---|---|

| Preentrenamiento | Entrenar GPT desde cero | 1000+ GPU, $10M+ | Meses |

| Ajuste fino completo | Especializar para medicina | 10-50 GPU | Días/semanas |

| LoRA | Agregar conocimiento de Python | 1-4 GPU | Horas/días |

Beneficios clave: • Eficiencia de parámetros: Reduce dramáticamente los parámetros entrenables. La variante QLoRA usa cuantización de 4-bit/8-bit para compatibilidad con una sola GPU de 24GB • Previene el olvido catastrófico: Congela parámetros originales, preservando conocimiento preentrenado • Desempeño comparable: Iguala o supera resultados de ajuste fino completo. Regularización incorporada previene sobreajuste en conjuntos de datos pequeños • Ahorro de recursos: Menos uso de memoria + tiempos de entrenamiento más rápidos Cuándo elegir:

- Ajuste fino completo: Dominios complejos (programación, matemáticas) donde la precisión es primordial

- LoRA: La mayoría de escenarios de ajuste fino de instrucciones con conjuntos de datos más pequeños - más eficiente e igualmente efectivo LoRA brinda eficiencia de recursos atractiva sin sacrificar desempeño para la mayoría de casos de uso.

Un análisis más profundo de la implementación y mejores prácticas

Implementar LoRA involucra un proceso estructurado, y varios frameworks y herramientas han surgido para simplificar el flujo de trabajo. Un ejemplo popular es el AI Toolkit para Visual Studio Code, que brinda una forma directa de crear un adaptador LoRA para modelos como el Phi Silica de Microsoft. Los desarrolladores pueden definir el modelo y brindar datos de entrenamiento de alta calidad en archivos JSON para generar un adaptador personalizado.

Al implementar LoRA, varias mejores prácticas pueden maximizar el desempeño y la calidad del modelo.

La calidad de los datos es clave: La efectividad de un adaptador LoRA depende altamente de la calidad y cantidad de los datos de entrenamiento. Se recomienda usar miles de ejemplos diversos y de alta calidad para lograr los mejores resultados.

Ajuste de hiperparámetros: Como cualquier proceso de aprendizaje automático, optimizar hiperparámetros es crítico. La tasa de aprendizaje, en particular, es altamente sensible para LoRA, y encontrar el valor óptimo a través de experimentación es esencial para un entrenamiento estable y efectivo.

Evaluación continua: Es crucial rastrear y evaluar el desempeño de diferentes métodos de ajuste fino. El seguimiento de experimentos asegura reproducibilidad, permite colaboración y ayuda a identificar las mejores configuraciones de entrenamiento.

LoRA en acción: casos de uso del mundo real

La eficiencia del ajuste fino LoRA lo convierte en un ajuste perfecto para una amplia gama de aplicaciones.

LLM específicos de dominio: Las empresas pueden usar LoRA para tomar un LLM de propósito general y adaptarlo a un sector específico, como finanzas o salud, para comprender terminología especializada y brindar respuestas más precisas. Esto permite la creación de asistentes virtuales poderosos y hechos a medida.

Modelos visuales mejorados: Más allá del texto, LoRA puede aplicarse a modelos de difusión de texto a imagen. Los desarrolladores pueden usar un factor de escala para controlar cuánto se ajusta el modelo para un estilo o salida particular.

Edge computing e IoT: La naturaleza liviana de los adaptadores LoRA los hace ideales para ejecutarse en dispositivos con recursos computacionales limitados, como teléfonos inteligentes o dispositivos IoT. Esto es crucial para aplicaciones donde la baja latencia es un requisito y enviar datos a una nube remota no es factible.

Desafíos y consideraciones

Aunque LoRA brinda muchas ventajas, no está libre de desafíos. La calidad y representatividad de los datos usados para el ajuste fino puede afectar significativamente el comportamiento del modelo. Si los datos están incompletos o contienen contenido dañino, el modelo puede heredar estos sesgos. El ajuste fino en un conjunto de datos estrecho también puede causar que un modelo se sobreajuste, potencialmente disminuyendo su capacidad de generalizar a nuevas entradas o escenarios. Por lo tanto, incluso con técnicas de ajuste fino eficientes, una comprensión profunda de los datos y un proceso de evaluación robusto siguen siendo críticos para un despliegue exitoso y responsable.

Conclusión: el futuro de la adaptación eficiente de IA

La introducción del ajuste fino LoRA marca un momento pivotal en el desarrollo de IA, democratizando el acceso a la personalización de modelos grandes y complejos. Al congelar la gran mayoría de los parámetros de un modelo y agregar matrices pequeñas y entrenables de bajo rango, LoRA resuelve el problema del consumo excesivo de recursos, haciendo que el ajuste fino sea una realidad práctica para una audiencia más amplia. Este enfoque no solo ahorra tiempo y costo sino que también ayuda a mitigar el riesgo de olvido catastrófico, asegurando que el conocimiento valioso de los modelos preentrenados se preserve.

El surgimiento de técnicas de ajuste fino eficiente de parámetros (PEFT), con LoRA en primer plano, está reformando cómo construimos y desplegamos IA. El futuro de la innovación en IA no se trata solo de crear modelos cada vez más grandes, sino de hacerlos más adaptables, accesibles y eficientes.

Construye aplicaciones impulsadas por IA ejecutando modelos de IA en la infraestructura altamente distribuida de Azion para suministrar inferencia escalable, de baja latencia y rentable — es una necesidad estratégica para desarrolladores que buscan crear soluciones de IA personalizadas y de alto desempeño en un mundo acelerado y consciente de los recursos.