Construir

AI Inference

Ejecuta inferencias de IA a escala global para impulsar aplicaciones más inteligentes.

Inferencia con latencia ultrabaja

Entrega inferencias de IA con latencia ultrabaja ejecutando modelos más cerca de los usuarios para respuestas instantáneas y experiencias sin interrupciones.

Escalado automático sin servidores

Escala cargas de trabajo de IA sin gestionar servidores ni clústeres. Aprovecha la arquitectura serverless de Azion para crecer bajo demanda, desde cero hasta picos masivos.

Alta disponibilidad

Mantén tus aplicaciones siempre disponibles. La arquitectura distribuida de Azion garantiza operación continua incluso ante fallos regionales o problemas de conectividad.

"Con Azion, podemos escalar nuestros modelos de IA propietarios sin tener que preocuparnos por la infraestructura. Estas soluciones inspeccionan millones de sitios web diariamente, detectando y neutralizando amenazas con rapidez y precisión, realizando el takedown más rápido del mercado."

Fabio Ramos

CEO

Optimiza tus modelos de IA a bajo costo

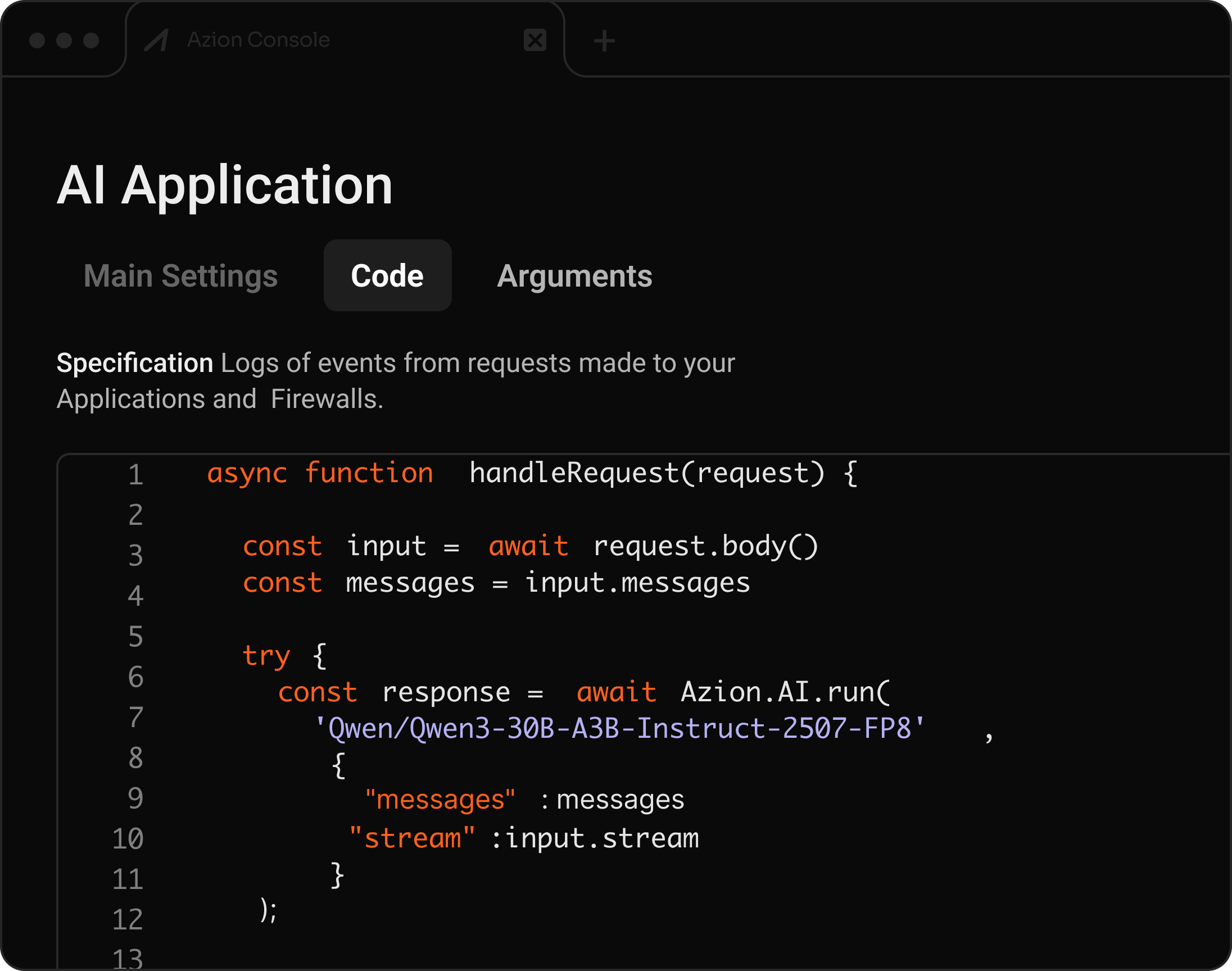

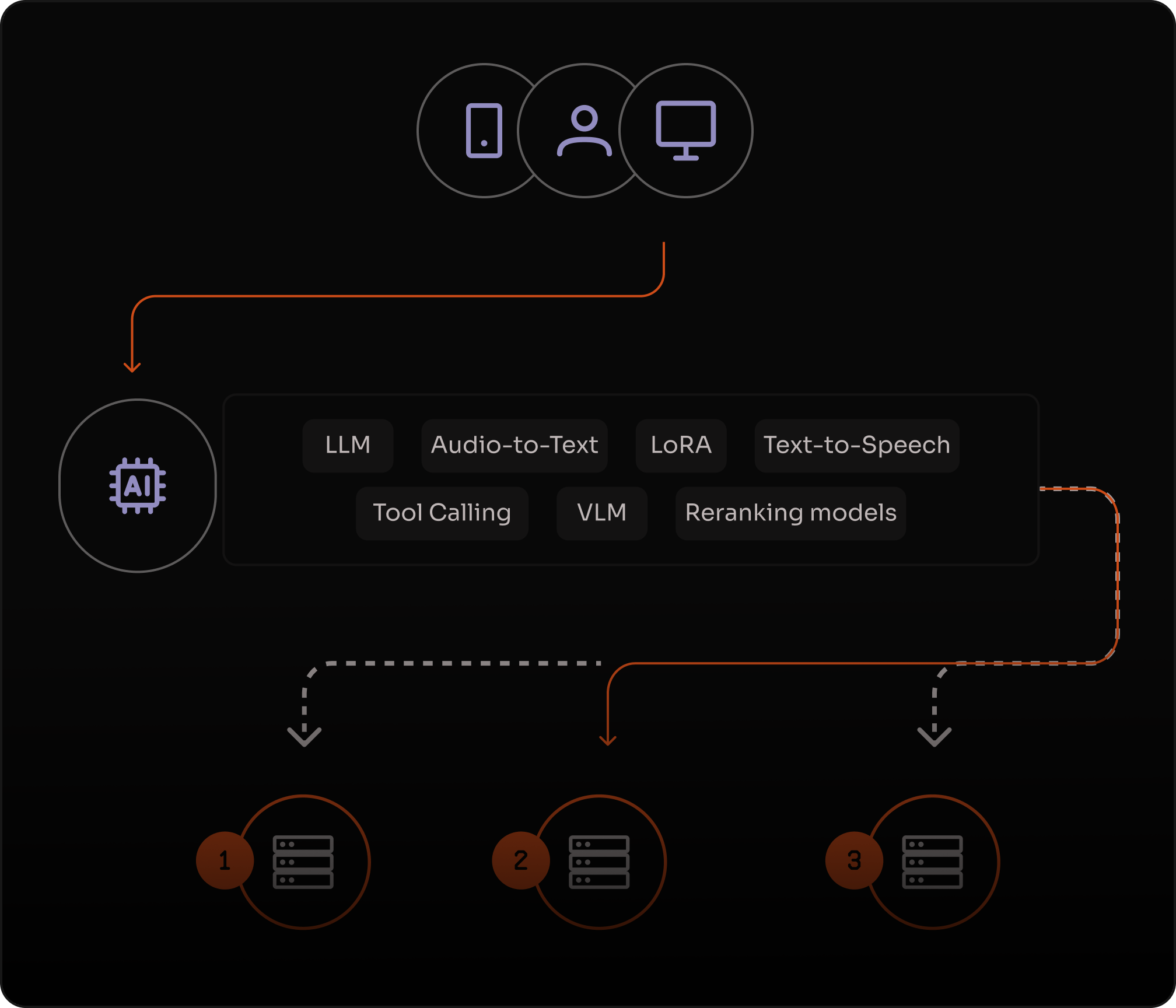

Ejecución de modelos en infraestructura distribuida

Despliega y ejecuta LLMs, VLMs, Embeddings, Audio a Texto, Texto a Imagen, Tool Calling, LoRA, Rerank y LLMs de codificación — todo integrado con aplicaciones distribuidas.

Migra tus aplicaciones rápidamente usando el mismo formato de API de OpenAI—solo cambia la URL.

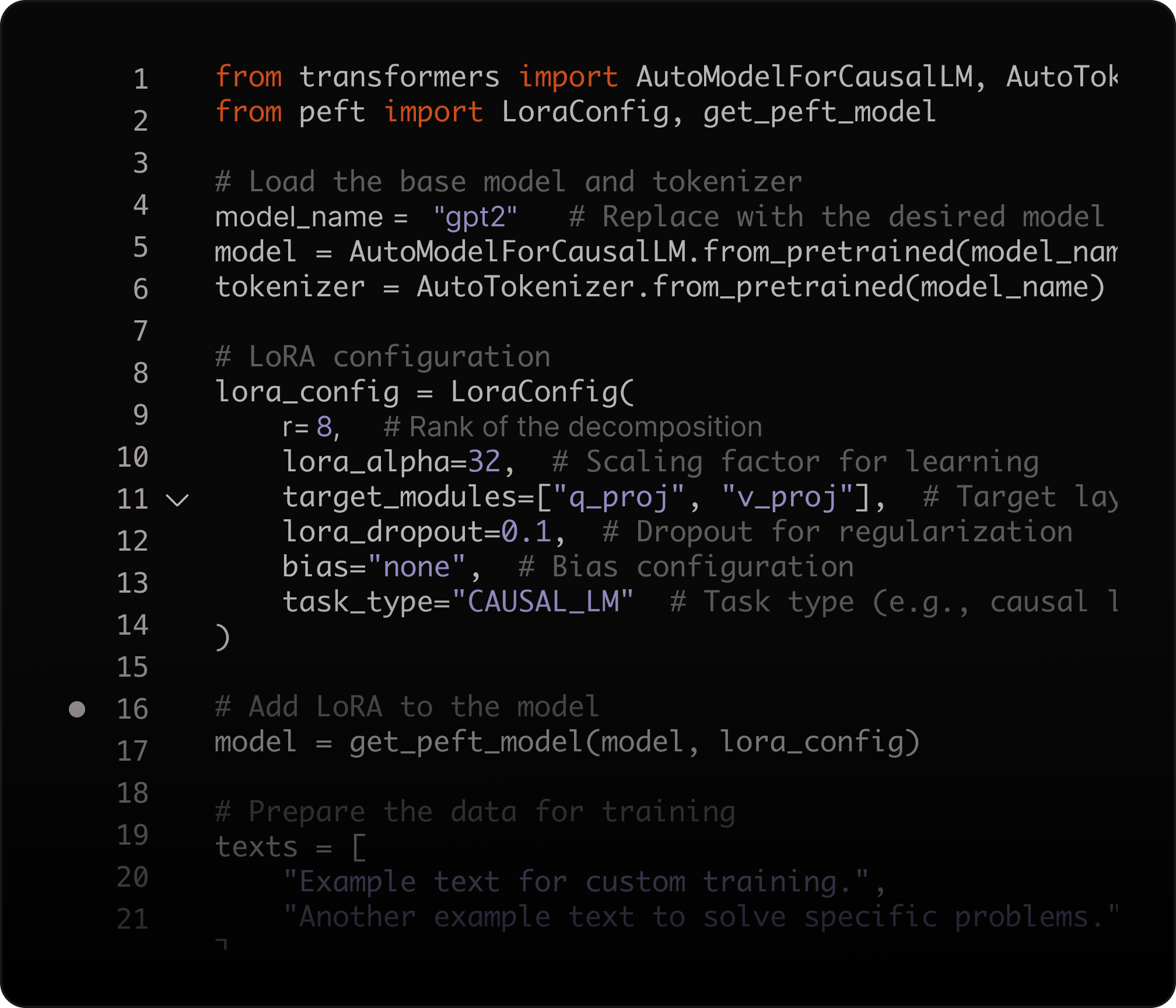

Ajuste fino de modelos

Afina modelos de IA con Low-Rank Adaptation (LoRA) para personalizar inferencias, optimizar el rendimiento y reducir los costes de entrenamiento.

Ajusta parámetros de forma eficiente y resuelve problemas complejos con un menor uso de recursos.