A nova era da customização de modelos

Modelos de AI tradicionalmente requerem fine-tuning intensivo em recursos para atender necessidades específicas de negócio, criando barreiras para muitos desenvolvedores e organizações devido a custos proibitivos e longos ciclos de desenvolvimento.

Desafio Principal: Adaptar modelos de bilhões de parâmetros eficientementeProblema Tradicional: Altos custos computacionais + desenvolvimento demoradoNo entanto, novas técnicas eficientes de adaptação estão democratizando o acesso à IA. LoRA Fine-Tuning (Adaptação de Baixo Rank) emerge como uma solução líder, permitindo que desenvolvedores especializem modelos pré-treinados para tarefas específicas—como encaixar anexos específicos em ferramentas de uso geral.

LoRA maximiza performance enquanto minimiza sobrecarga computacional e pegada de memória. Esta mudança de paradigma permite que desenvolvedores criem modelos customizados de alta performance sem os investimentos massivos tradicionalmente requeridos para fine-tuning completo, desbloqueando novos níveis de agilidade no desenvolvimento de IA.

Entendendo a base: pré-treinamento vs. fine-tuning

Antes de mergulhar no LoRA, é essencial entender a distinção entre pré-treinamento e fine-tuning. Pré-treinamento é o processo fundamental de construir um modelo do zero. Isso envolve alimentar um modelo com um dataset massivo e diverso e permitir que ele aprenda todos os seus parâmetros desde o início. Esta é uma tarefa monumental, demandando recursos computacionais imensos e uma vasta quantidade de dados.

Fine-tuning é uma abordagem mais direcionada. Começa com um modelo pré-treinado que já possui um entendimento amplo de um assunto. Um desenvolvedor então faz pequenos ajustes nos parâmetros do modelo para refiná-lo para uma tarefa específica downstream. Este processo requer significativamente menos dados e poder computacional do que pré-treinar um modelo do zero. No entanto, mesmo o fine-tuning tradicional pode ser caro e demorado, já que ainda requer modificar todo o conjunto de parâmetros.

Como funciona o fine-tuning LoRA

Em seu núcleo, Adaptação de Baixo Rank (LoRA) é uma técnica para rapidamente adaptar modelos de machine learning a novos contextos sem retreinar todo o modelo. O método funciona adicionando pequenas partes modificáveis ao modelo original, ao invés de alterar toda a estrutura. Esta abordagem ajuda desenvolvedores a expandir os casos de uso para seus modelos de uma forma muito mais rápida e eficiente em recursos.

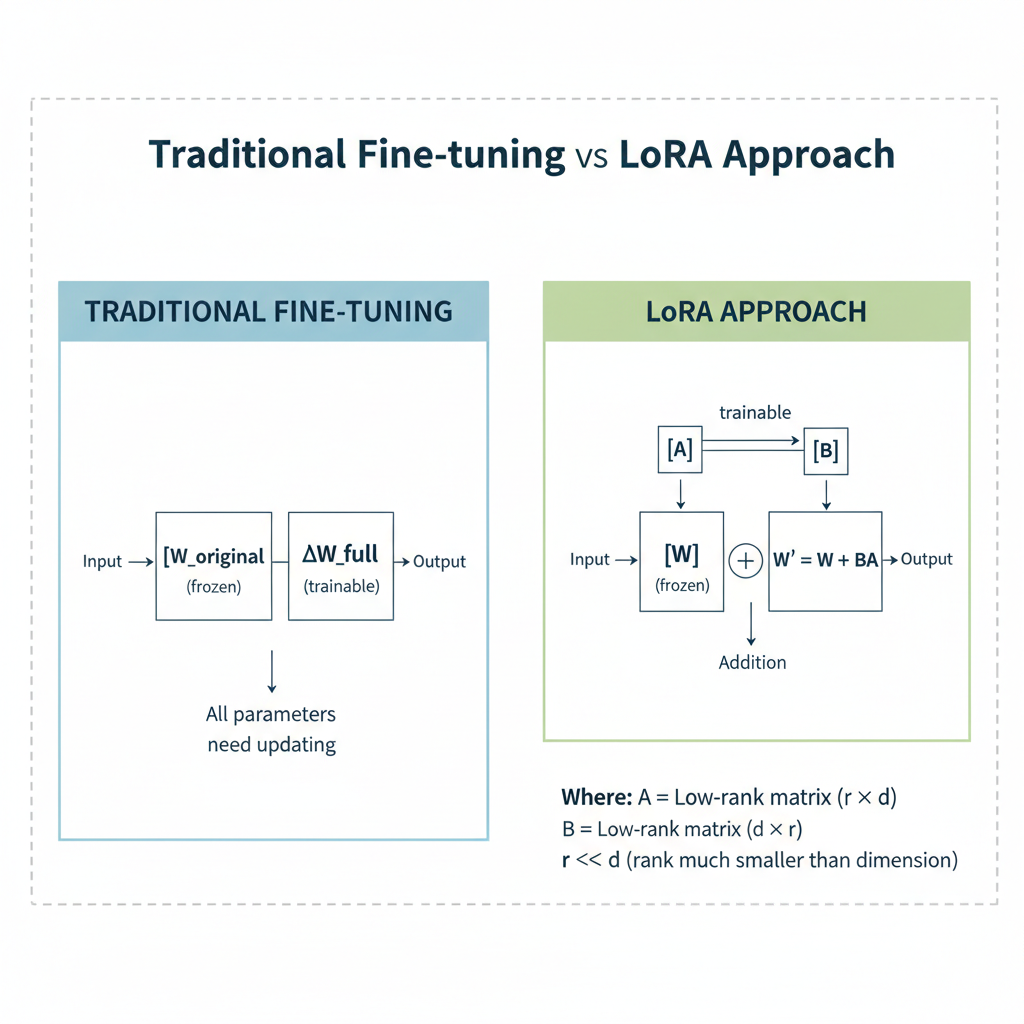

A genialidade técnica do LoRA está no seu uso de “matrizes de baixo rank”. No fine-tuning tradicional, o objetivo é alterar a matriz de peso original (W) de uma rede neural para se adequar a uma nova tarefa. A mudança em si é representada por uma matriz separada, ΔW. LoRA introduz um atalho inteligente: ao invés de tentar calcular e aplicar a matriz ΔW completa e complexa, ela a decompõe em duas matrizes muito menores de rank inferior, A e B. A matriz de peso atualizada se torna W′=W+B·A, onde a matriz de peso original (W) é mantida “congelada” e inalterada.

Tradicional: W' = W + ΔWLoRA: W' = W + B·AOnde:- W = Matriz de peso original (congelada)- ΔW = Matriz completa de atualização de parâmetros- A = Matriz de baixo rank (treinável)- B = Matriz de baixo rank (treinável)- B·A = Aproximação de baixo rank de ΔWEsta decomposição é crucial para reduzir a sobrecarga computacional. O número de parâmetros treináveis é drasticamente reduzido porque as pequenas matrizes A e B têm muito menos valores que a matriz de peso original. Por exemplo, uma grande matriz de peso pode ter bilhões de parâmetros, mas com LoRA, os parâmetros treináveis para um modelo como GPT-3 podem ser reduzidos de 175 bilhões para cerca de 18 milhões. Isso resulta em economias significativas em memória GPU e poder de processamento, tornando-se uma solução altamente custo-efetiva para adaptar modelos grandes.

Comparação de redução de parâmetros

| Componente do Modelo | Fine-tuning Tradicional | Fine-tuning LoRA |

|---|---|---|

| Parâmetros GPT-3 | 175 bilhões | ~18 milhões |

| Fator de Redução | 1× (baseline) | ~9.700× menor |

| Uso de Memória | Alto | Significativamente reduzido |

| Velocidade de Treinamento | Lenta | Rápida |

| Custo | Alto | Baixo |

As vantagens do LoRA sobre fine-tuning completo

LoRA fornece vários benefícios-chave que o tornam uma alternativa convincente ao fine-tuning completo.

Comparação prática

| Estágio | Exemplo GPT | Recursos Necessários | Tempo |

|---|---|---|---|

| Pré-treinamento | Treinar GPT do zero | 1000+ GPUs, $10M+ | Meses |

| Fine-tuning Completo | Especializar para medicina | 10-50 GPUs | Dias/semanas |

| LoRA | Adicionar conhecimento Python | 1-4 GPUs | Horas/dias |

Benefícios Principais: • Eficiência de Parâmetros: Reduz drasticamente parâmetros treináveis. Variante QLoRA usa quantização de 4-bit/8-bit para compatibilidade com GPU única de 24GB • Previne Esquecimento Catastrófico: Congela parâmetros originais, preservando conhecimento pré-treinado • Performance Comparável: Iguala ou supera resultados de fine-tuning completo. Regularização incorporada previne overfitting em datasets pequenos • Economia de Recursos: Menos uso de memória + tempos de treinamento mais rápidos Quando Escolher:

- Fine-tuning Completo: Domínios complexos (programação, matemática) onde precisão é fundamental

- LoRA: Maioria dos cenários de fine-tuning de instrução com datasets menores - mais eficiente e igualmente efetivo LoRA oferece eficiência de recursos convincente sem sacrificar performance para a maioria dos casos de uso.

Um mergulho mais profundo na implementação e melhores práticas

Implementar LoRA envolve um processo estruturado, e várias frameworks e ferramentas emergiram para simplificar o fluxo de trabalho. Um exemplo popular é o AI Toolkit para Visual Studio Code, que fornece uma maneira direta de criar um adaptador LoRA para modelos como o Phi Silica da Microsoft. Desenvolvedores podem definir o modelo e fornecer dados de treinamento de alta qualidade em arquivos JSON para gerar um adaptador customizado.

Ao implementar LoRA, várias melhores práticas podem maximizar performance e qualidade do modelo.

Qualidade dos dados é fundamental: A efetividade de um adaptador LoRA é altamente dependente da qualidade e quantidade dos dados de treinamento. É recomendado usar milhares de exemplos diversos e de alta qualidade para alcançar os melhores resultados.

Ajuste de hiperparâmetros: Como qualquer processo de machine learning, otimizar hiperparâmetros é crítico. A taxa de aprendizado, em particular, é altamente sensível para LoRA, e encontrar o valor ótimo através de experimentação é essencial para treinamento estável e efetivo.

Avaliação contínua: É crucial rastrear e avaliar a performance de diferentes métodos de fine-tuning. Rastreamento de experimentos garante reprodutibilidade, permite colaboração e ajuda a identificar as melhores configurações de treinamento.

LoRA em ação: casos de uso do mundo real

A eficiência do fine-tuning LoRA o torna perfeito para uma ampla gama de aplicações.

LLMs específicos de domínio: Empresas podem usar LoRA para pegar um LLM de propósito geral e adaptá-lo para uma indústria específica, como finanças ou saúde, para entender terminologia especializada e fornecer respostas mais precisas. Isso permite a criação de assistentes virtuais poderosos e customizados.

Modelos visuais aprimorados: Além de texto, LoRA pode ser aplicado a modelos de difusão texto-para-imagem. Desenvolvedores podem usar um fator de escala para controlar o quanto o modelo é ajustado para um estilo ou saída particular.

Edge computing e IoT: A natureza leve dos adaptadores LoRA os torna ideais para rodar em dispositivos com recursos computacionais limitados, como smartphones ou dispositivos IoT. Isso é crucial para aplicações onde baixa latência é um requisito e enviar dados para uma nuvem remota não é viável.

Desafios e considerações

Embora LoRA ofereça muitas vantagens, não está livre de desafios. A qualidade e representatividade dos dados usados para fine-tuning podem afetar significativamente o comportamento do modelo. Se os dados estão incompletos ou contêm conteúdo prejudicial, o modelo pode herdar esses vieses. Fine-tuning em um dataset restrito também pode causar overfitting do modelo, potencialmente diminuindo sua capacidade de generalizar para novas entradas ou cenários. Portanto, mesmo com técnicas eficientes de fine-tuning, um entendimento profundo dos dados e um processo robusto de avaliação ainda são críticos para implantação bem-sucedida e responsável.

Conclusão: o futuro da adaptação eficiente de IA

A introdução do fine-tuning LoRA marca um momento pivotal no desenvolvimento de AI, democratizando acesso à customização de modelos grandes e complexos. Ao congelar a vasta maioria dos parâmetros de um modelo e adicionar pequenas matrizes treináveis de baixo rank, LoRA resolve o problema de consumo excessivo de recursos, tornando fine-tuning uma realidade prática para um público mais amplo. Esta abordagem não apenas economiza tempo e custo mas também ajuda a mitigar o risco de esquecimento catastrófico, garantindo que o conhecimento valioso de modelos pré-treinados seja preservado.

A ascensão de técnicas de fine-tuning eficiente em parâmetros (PEFT), com LoRA na vanguarda, está remodelando como construímos e implantamos AI. O futuro da inovação em AI não é apenas sobre criar modelos cada vez maiores, mas sobre torná-los mais adaptáveis, acessíveis e eficientes.

Construa aplicações alimentadas por AI executando modelos de IA na infraestrutura altamente distribuída da Azion para entregar inferência escalável, de baixa latência e custo-efetiva — é uma necessidade estratégica para desenvolvedores buscando criar soluções de IA customizadas e de alta performance em um mundo acelerado e consciente de recursos.