A rede distribuída mais confiável do planeta

30ms

para alcançar qualquer lugar nas Américas e na Europa

3.3k

ASNs diretamente conectados à rede da Azion

100%

disponibilidade garantida por SLA

100+

locations ao redor do mundo

Rede com Melhor Desempenho, Disponibilidade e Resiliência

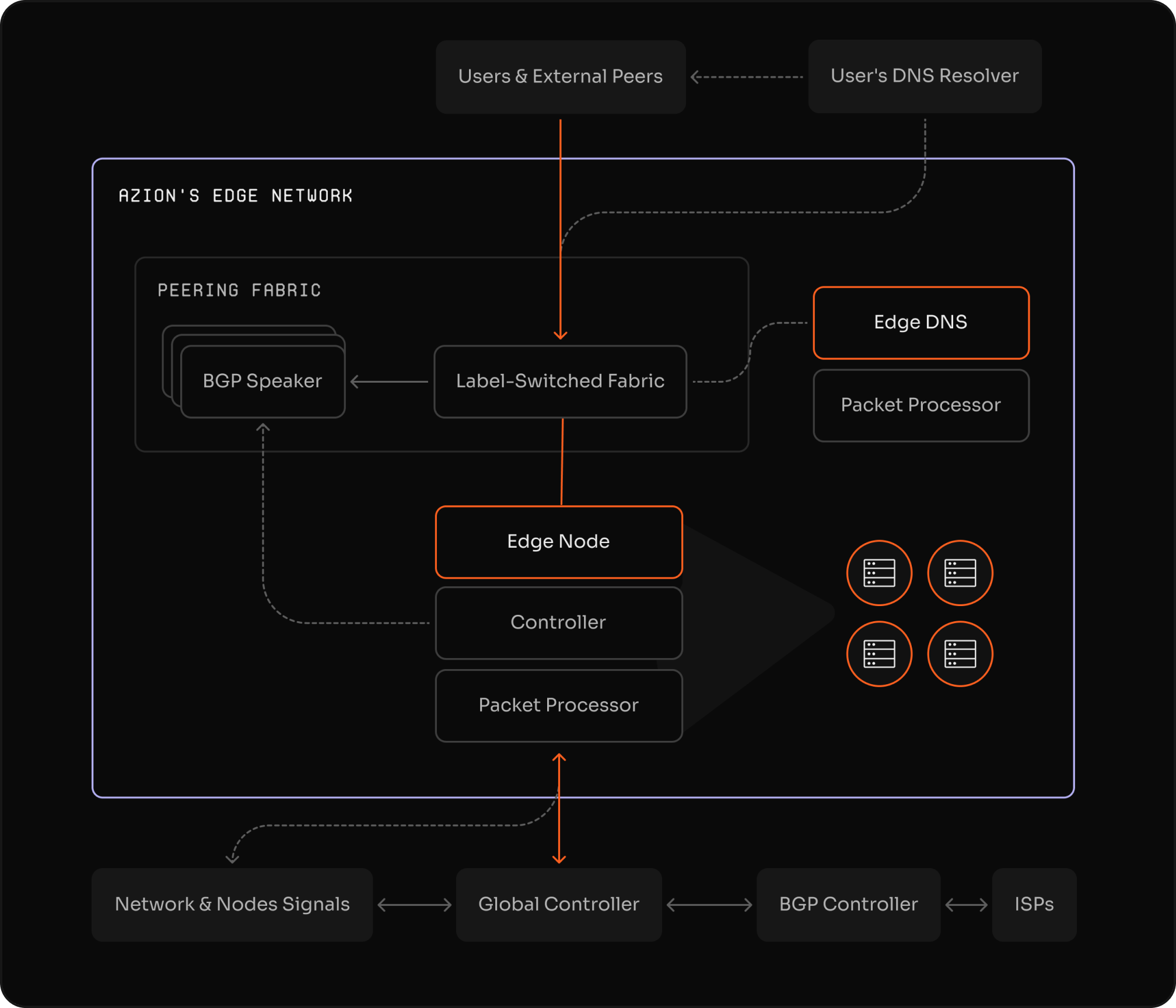

- Nossa arquitetura altamente distribuída inclui nodes estrategicamente localizados dentro das redes de última milha dos ISPs (Provedores de Serviços de Internet)

- Conectividade com múltiplos PTTs (Pontos de Troca de Tráfego), peerings privados e públicos

- Provedores de trânsito de Tier 1 ao redor do mundo.

Segurança direto na Rede

- Defesa DDoS em cada edge location e se conecta a vários centros de mitigação em todo o mundo, garantindo total confiabilidade e sem afetar o desempenho.

- Azion é Membro MANRS (Mutually Agreed Norms for Routing Security), da Internet Society.